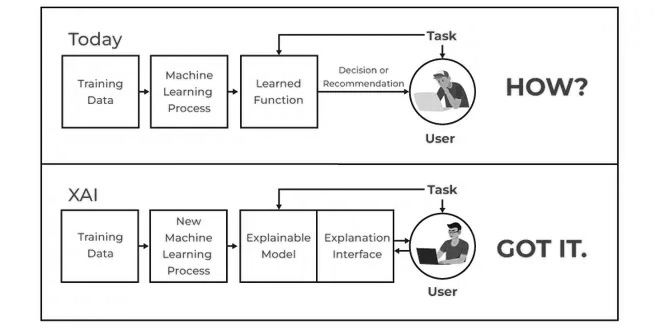

Je vois souvent une confusion. Les gens demandent la différence entre l’IA et l’IA Explicable (XAI). Pensez-y comme ceci. L’Intelligence Artificielle (IA) est le domaine qui construit des systèmes intelligents pour accomplir des tâches. C’est l’ingénieur qui bâtit une pièce complexe et fermée. La XAI, elle, est un ensemble de méthodes spécifiques à l’intérieur de l’IA. Elle nous donne les clés pour ouvrir cette pièce et comprendre ce qui s’y passe. La XAI s’attaque directement à la nature de “boîte noire” de nombreux modèles complexes.

Le but principal de l’IA traditionnelle est la performance. L’exactitude. L’exécution de la tâche. La XAI a un objectif différent. Elle vise la transparence, l’interprétabilité et la confiance. Elle fournit des explications claires et compréhensibles sur la manière dont les décisions sont prises. C’est essentiel pour la surveillance humaine, la conformité réglementaire et une utilisation éthique.

Pourquoi l’IA Explicable est-elle Cruciale ?

Le besoin de transparence n’est pas un luxe académique. C’est une nécessité pratique dans les domaines à haut risque. La santé, la finance, la justice. L’objectif est de bâtir la confiance et de permettre une gestion efficace des systèmes d’IA.

Pour les Utilisateurs et la Société

- Instaurer la Confiance : Un utilisateur fait confiance à un système s’il comprend sa logique. C’est la base de l’adoption.

- Garantir l’Équité : La XAI aide à identifier et corriger les biais dans les données ou les algorithmes. Cela mène à des résultats plus justes, que ce soit pour une approbation de prêt ou un processus de recrutement.

- Améliorer la Sécurité : Dans une voiture autonome, comprendre le raisonnement de l’IA peut éviter des erreurs catastrophiques. L’opérateur humain peut valider les décisions critiques.

Cette confiance est le pilier d’une collaboration homme-IA réussie. Un spécialiste ou un militaire est plus efficace quand il comprend son partenaire IA.

Pour les Organisations et les Développeurs

- Conformité Réglementaire : Des lois comme le RGPD ou l’AI Act de l’UE exigent des explications pour les décisions automatisées. La XAI est la solution pour réduire les risques juridiques. Construire la confiance dans l’IA est un rôle clé de l’explicabilité.

- Débogage Efficace : La transparence permet aux développeurs de trouver et corriger les failles. Si un modèle identifie un chien en se concentrant sur l’herbe en arrière-plan, la XAI le montrera.

- Amélioration des Modèles : En comprenant les erreurs, nous améliorons la précision et la performance globale du système.

- Nouvelles Perspectives : Décortiquer le fonctionnement d’un modèle peut révéler des corrélations cachées. Ces découvertes mènent à de nouvelles stratégies commerciales.

Les Catégories de l’IA Explicable

Les méthodes de la XAI ne sont pas toutes identiques. Je les classe généralement selon trois axes principaux. Le moment où l’explication est générée, sa portée, et sa spécificité au modèle.

Par Conception et Timing

- Modèles Intrinsèquement Interprétables : Ces modèles sont transparents par nature. Leur logique de décision est claire. Pensez à une régression linéaire simple ou un arbre de décision.

- Techniques d’Explication Post-hoc : Ces méthodes s’appliquent après l’entraînement d’un modèle complexe. Elles sont nécessaires pour les boîtes noires comme les réseaux de neurones profonds.

Par Portée de l’Explication

- Interprétation Locale : Ces méthodes expliquent une prédiction individuelle. Elles répondent à la question : “Pourquoi cette décision a-t-elle été prise pour cette donnée précise ?”

- Interprétation Globale : Ici, l’objectif est d’expliquer le comportement général du modèle sur l’ensemble des données. Quelles caractéristiques influencent le plus les résultats en général ?

Par Spécificité du Modèle

- Méthodes Agnostiques au Modèle : Ces techniques sont flexibles. Elles peuvent être appliquées à n’importe quel modèle d’apprentissage automatique, car elles traitent le modèle comme une boîte noire et analysent les relations entrée-sortie.

- Méthodes Spécifiques au Modèle : Celles-ci sont conçues pour des architectures spécifiques, comme les réseaux de neurones. Elles offrent des explications plus détaillées mais ne sont pas généralisables.

Le choix de la méthode dépend entièrement des besoins du projet. Pour en savoir plus, une étude comparative des approches agnostiques et spécifiques est une excellente lecture.

Les Techniques Concrètes de l’IA Explicable

Voyons maintenant quelques-unes des clés les plus utilisées pour ouvrir ces boîtes noires.

Modèles Simples par Nature

La première approche est de ne pas créer de boîte noire du tout.

- Régression Linéaire/Logistique : La prédiction est une somme pondérée des entrées. Les coefficients montrent directement l’influence de chaque caractéristique. Simple. Direct.

- Arbres de Décision : Le raisonnement suit un ensemble de règles “si-alors”. Le chemin est facile à tracer.

Techniques d’Explication Post-Hoc

Quand la complexité est nécessaire, nous utilisons des outils pour l’éclairer après coup.

- LIME (Local Interpretable Model-agnostic Explanations) : LIME crée un modèle simple et local pour expliquer une seule prédiction. Il perturbe les données d’entrée et observe les changements pour déterminer l’importance des caractéristiques.

- SHAP (SHapley Additive exPlanations) : Basé sur la théorie des jeux, SHAP assigne une valeur d’importance à chaque caractéristique. Il représente sa contribution à la prédiction. SHAP fournit des explications locales et globales.

- Explications Contrefactuelles : Elles identifient le plus petit changement nécessaire pour obtenir un résultat différent. Par exemple : “Votre prêt aurait été approuvé si votre revenu était supérieur de 5 000 $”.

Approches Basées sur la Visualisation

Une image vaut mille mots, surtout en vision par ordinateur.

- Cartes de Saliency : Ces cartes thermiques mettent en évidence les pixels d’une image qui ont le plus influencé une décision.

- Grad-CAM : Très populaire pour les réseaux de neurones convolutifs (CNN), cette méthode produit des cartes thermiques montrant où le modèle “regardait” dans une image.

- Mécanismes d’Attention : Dans les modèles de type Transformer, les poids d’attention peuvent être visualisés pour montrer sur quels mots ou patchs d’image le modèle s’est concentré.

L’IA Explicable en Action : Exemples du Monde Réel

Santé et Diagnostic Médical

Imaginez un modèle d’IA analysant des radiographies pulmonaires. Une technique comme Grad-CAM génère une carte thermique. Elle surligne la lésion suspecte exacte sur laquelle le modèle s’est basé pour son diagnostic de cancer. Le radiologue peut alors valider ce raisonnement. Il ne fait pas aveuglément confiance. Il collabore avec l’IA. De même, pour l’évaluation du risque patient, la XAI explique quels facteurs (tension, âge) ont le plus pesé dans le score.

Finance et Banque

Votre demande de prêt est rejetée par une IA. La loi exige une explication. La XAI la fournit. Des techniques comme SHAP ou les explications contrefactuelles précisent les facteurs financiers responsables (historique de crédit, ratio dette/revenu) et ce qui devrait changer pour une approbation. Pour la détection de fraude, la XAI explique à l’analyste pourquoi une transaction est suspecte (montant, lieu, fréquence anormale), accélérant l’enquête.

Véhicules Autonomes

Une voiture autonome freine brusquement. La panique est évitée si le système peut expliquer sa décision. La XAI peut détailler la logique : “Détection d’un piéton entrant sur la route, manœuvre d’évitement de collision calculée”. La sécurité repose sur cette transparence.

Les Outils pour Mettre en Pratique l’IA Explicable

Pour implémenter ces techniques, nous disposons d’une panoplie d’outils, principalement des bibliothèques open-source et des plateformes commerciales.

Bibliothèques Python Open-Source

| Outil | Description |

|---|---|

| SHAP | Approche basée sur la théorie des jeux pour des explications locales et globales. Le code est sur son dépôt GitHub. |

| LIME | Explique les prédictions individuelles via des modèles substituts locaux. |

| InterpretML | Un package Microsoft qui regroupe de nombreuses techniques d’interprétabilité. |

| Captum | Une bibliothèque de PyTorch pour l’interprétabilité des modèles de deep learning. |

| AI Explainability 360 (AIX360) | Une boîte à outils complète d’IBM Research. |

| ELI5 (Explain Like I’m 5) | Une bibliothèque pour déboguer et inspecter des classifieurs de manière lisible. |

Plateformes Commerciales

Des entreprises intègrent la XAI dans leurs solutions.

- Google’s What-If Tool (WIT) : Un outil visuel interactif pour sonder les modèles sans écrire de code.

- DataRobot : Offre des fonctionnalités XAI intégrées dans sa plateforme de machine learning automatisé.

- ServiceNow & Qlik : Incorporent la XAI pour la transparence dans les opérations informatiques ou l’évaluation des risques.

Ces outils sont essentiels. Ils permettent aux data scientists et aux développeurs de s’assurer que leurs systèmes d’IA sont non seulement précis, mais aussi transparents, équitables et dignes de confiance. C’est la clé pour une IA responsable et efficace.

Pour approfondir vos compétences, je vous invite à consulter nos formations en IA pour ingénieurs, où nous maîtrisons l’ingénierie de l’intelligence artificielle.

Conseils & astuces

Commencez simple, puis montez en puissance : Avant de vous lancer dans des techniques complexes de “boîte noire” comme SHAP ou LIME, familiarisez-vous avec les modèles intrinsèquement interprétables. La régression linéaire ou les arbres de décision sont d’excellents points de départ pour comprendre les bases de l’explicabilité.

Connaissez votre public : L’explication parfaite n’existe pas. Adaptez la profondeur et le vocabulaire de votre explication à celui qui la reçoit. Un développeur aura besoin de détails techniques différents de ceux d’un dirigeant ou d’un régulateur.

Combinez les techniques pour une vue complète : Rarement une seule méthode XAI suffira. J’utilise souvent une combinaison, par exemple SHAP pour comprendre les impacts globaux des fonctionnalités et LIME pour décortiquer une prédiction individuelle particulièrement délicate.

La qualité des données est la base de toute bonne explication : Rappelez-vous que si vos données d’entraînement sont biaisées ou de mauvaise qualité, les explications générées par XAI le seront aussi. Une explication n’est utile que si elle est basée sur des informations fiables.

Intégrez l’XAI dès la phase de conception : Ne considérez pas l’explicabilité comme une réflexion après coup. En pensant à la transparence dès les premières étapes de votre projet IA, vous concevrez des systèmes naturellement plus compréhensibles et éthiques.

Maîtrisez l’art de la communication : Comprendre les algorithmes est une chose, les expliquer clairement à des non-experts en est une autre. Développez vos compétences à traduire des concepts techniques complexes en un langage simple et impactant, c’est crucial pour l’adoption et la confiance.

FAQ

Qu’est-ce que l’IA Explicable (XAI) ?

L’IA Explicable, ou XAI, est un domaine clé visant à rendre les décisions des systèmes d’IA compréhensibles et dignes de confiance. Elle s’attaque à la nature de “boîte noire” des modèles complexes, où le “pourquoi” d’une décision est souvent opaque.

Pourquoi l’XAI est-elle si importante ?

Son importance est cruciale, surtout dans les domaines à haut risque. L’XAI bâtit la confiance, identifie les biais, facilite le débogage et l’amélioration des modèles, et assure la conformité réglementaire. Elle est essentielle pour une utilisation responsable et éthique de l’IA.

Quelles sont les principales catégories de méthodes XAI ?

Je distingue trois catégories : les modèles intrinsèquement interprétables (régression linéaire, arbres de décision), les techniques post-hoc appliquées après l’entraînement d’un modèle complexe (LIME, SHAP), et les approches visuelles qui montrent l’influence des données d’entrée (cartes de saillance).

Quels sont les bénéfices concrets de l’intégration de l’XAI ?

L’XAI renforce la confiance, assure l’équité, améliore la prise de décision humaine et aide à la conformité réglementaire. Pour les développeurs, elle permet un débogage efficace et l’amélioration continue des modèles. C’est un atout majeur pour une IA fiable et transparente.

Comment l’XAI se distingue-t-elle de l’IA “traditionnelle” ?

L’IA se concentre sur la performance. L’XAI, elle, rend les processus de décision compréhensibles et transparents. Alors que l’IA peut être une “boîte noire”, l’XAI l’ouvre pour montrer “pourquoi” une décision a été prise, crucial pour l’éthique et la supervision humaine.

Pouvez-vous donner des exemples concrets d’application de l’XAI ?

En santé, l’XAI aide les radiologues à valider le diagnostic d’un modèle d’IA pour détecter des cancers en montrant les zones d’intérêt. Dans la finance, elle explique les refus de prêts. Pour les véhicules autonomes, l’XAI justifie les manœuvres. Elle est essentielle partout où la transparence des décisions est exigée.

Quels outils sont disponibles pour implémenter l’XAI ?

J’utilise des bibliothèques open-source comme SHAP et LIME pour leurs explications post-hoc agnostiques au modèle. D’autres outils incluent ELI5, InterpretML et Captum pour PyTorch. Des plateformes commerciales comme Google What-If Tool ou DataRobot intègrent également des fonctionnalités XAI. Ces outils sont indispensables aux data scientists.